SelfHostLLM

ストックにはログインが必要です

LLM推論に必要なGPUメモリを計算する

Artificial Intelligence

Developer Tools

GitHub

Open Source

概要

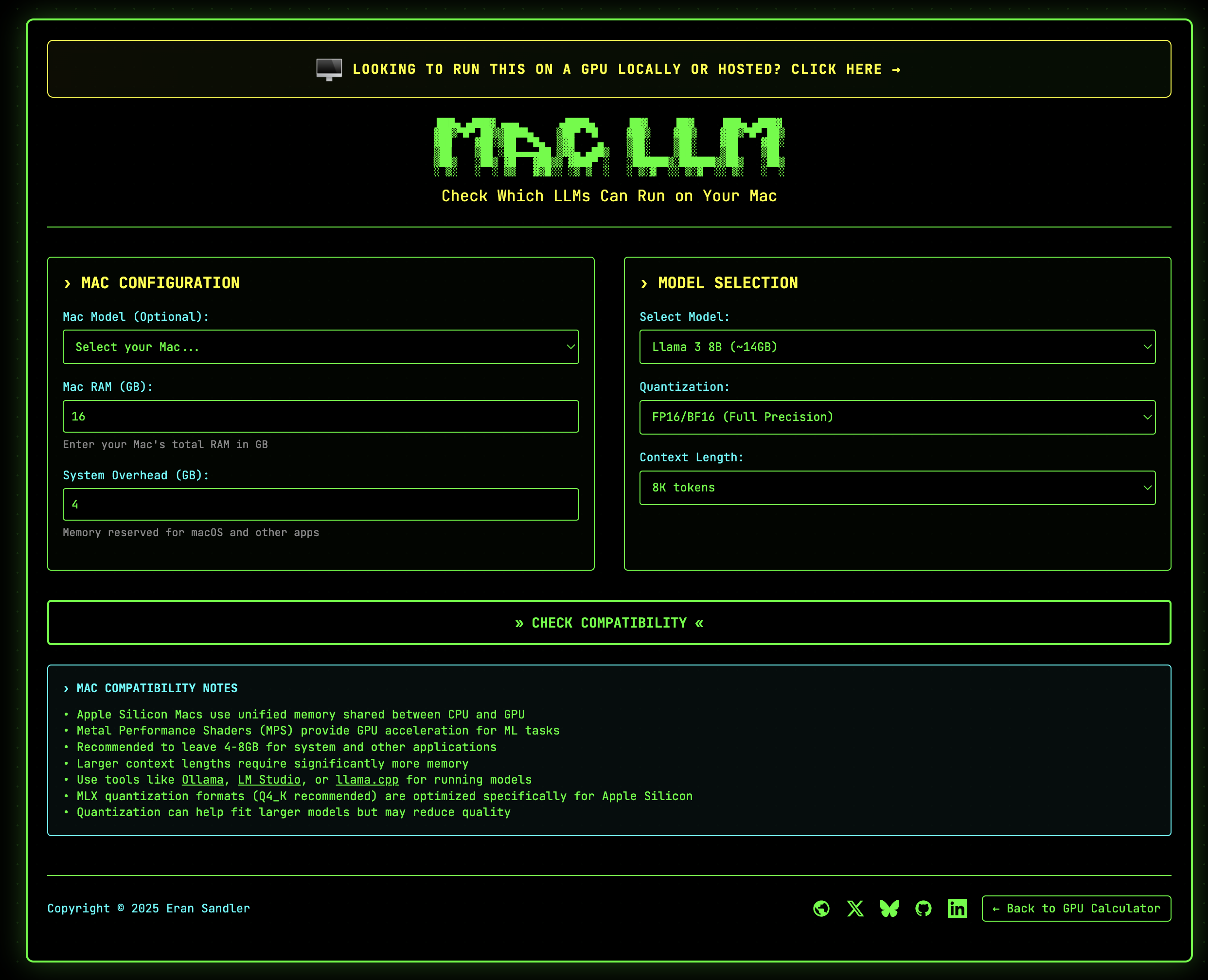

SelfHostLLMは自己ホスト型のAIデプロイメントのために設計されたツールです。このプロダクトは、特にユーザーがLlama、Qwen、DeepSeek、MistralなどのAIモデルを使用する際のGPUメモリ要件を正確に計算するのをサポートします。

特徴

- GPUメモリ要件の計算: 具体的な需要に基づいて、必要なGPUメモリを見積もることができます。

- 最大同時リクエスト数の算出: 自己ホスト型のインフラにおいて、どれだけのリクエストを同時に処理できるかを把握できます。

- 効率的なAIインフラ計画: より良い計画のための情報を提供し、ユーザーのAIプロジェクトをスムーズに進行させます。

追加の要望

著者は、今後Appleシリコンのサポートも希望しています。これは、さらなる拡張性と柔軟性をもたらすものとなるでしょう。

SelfHostLLMを利用して、あなたのAIプロジェクトを一歩前進させてみましょう。

投票数: 115