OLMo 2 32B

ストックにはログインが必要です

Ai2から初の完全オープンなSOTAモデル

Artificial Intelligence

GitHub

Open Source

概要

OLMo 2 32Bは、アレン人工知能研究所(Ai2)から提供される完全にオープンな大規模言語モデル(LLM)です。これにより、データ、コード、重みがすべて公開されています。

特徴

- パラメータ数: 32Bパラメータで、中規模の範囲に位置。

- 訓練データ: 6兆トークンを使用し、二段階の事前学習プロセスを実施。

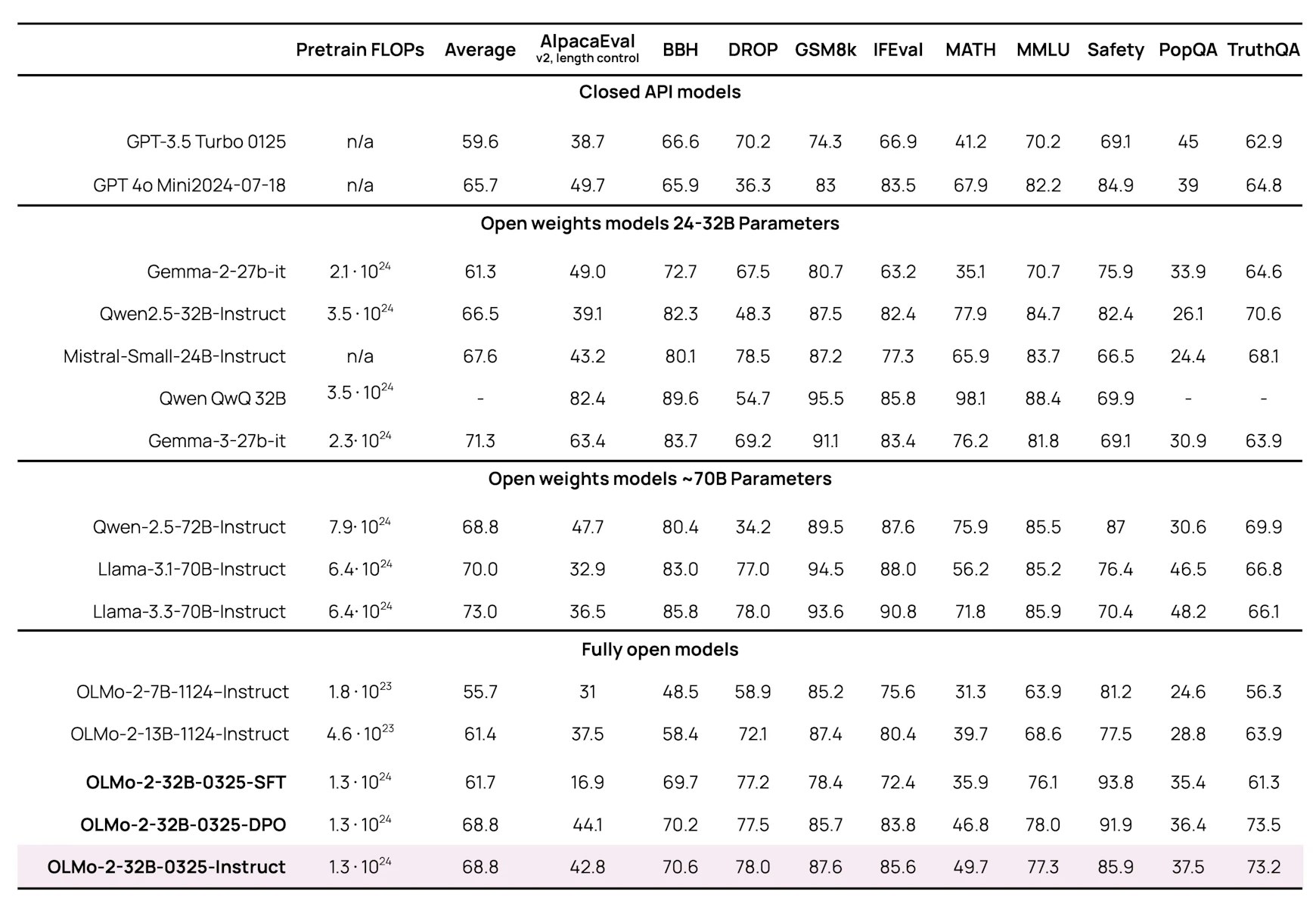

- 性能: GPT-3.5 TurboやGPT-4o miniと比較可能なパフォーマンスを発揮。

- 訓練技術: GRPOやRLVRを利用した効率的な訓練が行われています。

- ライセンス: Apache 2.0ライセンスの下で、モデル、訓練データ、コードが公開。

このリリースは、研究者や開発者に対し、能力の高いLLMとその訓練パイプラインへの完全なアクセスを提供し、Ai2の透明性への取り組みを強調しています。OLMo 2 32Bを使って、新たな可能性を試してみてください。

投票数: 2